In Daten verborgenes Wissen

Was alles möglich ist.

Auswahl der Stichprobe und die Sache mit der Signifikanz

Natürlich startet eine quantitative Auswertung mit einer Forschungsfrage, aus der, mit Hilfe von Fachliteratur, ein Fragebogen entwickelt wird, der sich zielgruppenspezifisch an die Befragten richtet. In vielen Fällen wird auch auf vorhandene, bereits getestete Fragebögen zurückgegriffen. Wie ein guter Fragebogen auszusehen hat, war nicht Teil des Workshops, wohl aber, an wie viele Befragte er sich richten sollte.

Wie wir erfuhren, sind bei sehr großen Grundgesamtheiten, (z.B. allen Autobesitzer:innen Deutschlands) erste relativ verlässliche Ergebnisse ab einer Stichprobe von 500 Befragten zu erwarten. Die Irrtumswahrscheinlichkeit beträgt dann nur noch ca. 5%. Zusätzlich sollte die Stichprobe der üblichen Durchmischung der Zielgruppe entsprechen, die es zuvor durch Recherche erst einmal zu bestimmen gilt. Für alle quantitativen Befragungen unter der genannten Fallzahlgrenze steigt die Fehlerwahrscheinlichkeit und sinkt die Aussagekraft der Befragung. Bei einer geringeren Grundgesamtheit kann die Stichprobe kleiner ausfallen. Dafür gibt es Berechnungsformeln. Diese Formeln liegen auch diversen Online-Tools zu Grunde liegen, die man als Arbeitserleichterung einsetzen kann.

Multivariate Analysen holen das Beste aus Befragungsdaten

Markus Schubert

Conoscope

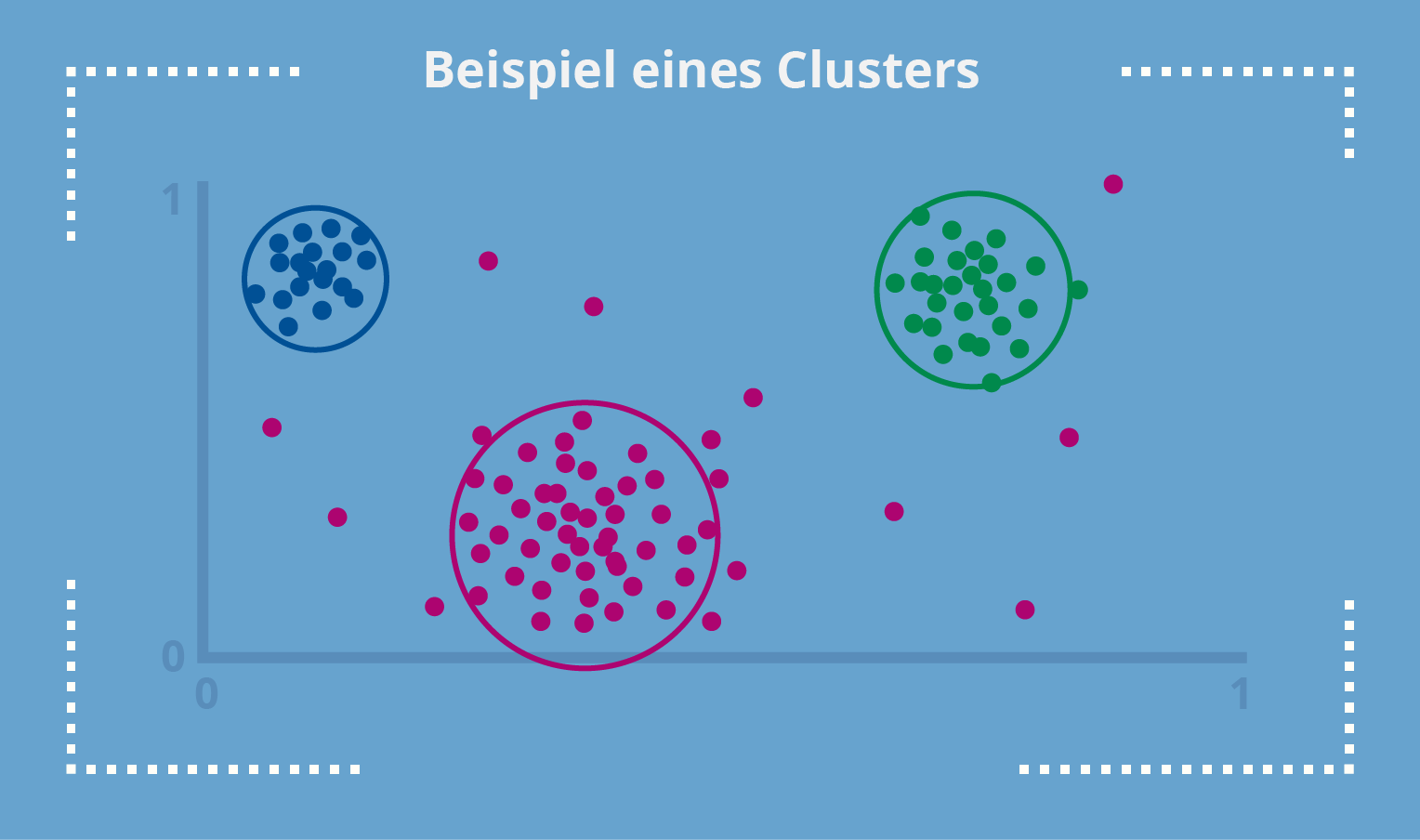

Vom Clustering zur Interpretation

Es lohnt sich

Es lohnt sich also, sich genauer mit erhobenen Daten zu befassen. Auch aus Befragungen, deren Befragungsbögen nicht perfekt waren, lassen sich durch gute Auswertung oft noch weitere Erkenntnisse gewinnen oder zumindest Hypothesen für Folgebefragungen bilden.

Ein Eintages-Workshop reicht natürlich nicht aus, um alles zu begreifen oder anwenden zu können, deshalb haben bereits individuelle Vertiefungen stattgefunden. Aber selbst ein einziger Workshop zeigt bereits auf, was in der Datenanalyse möglich und machbar ist und sensibilisiert für die Befragung.