KI-gestützte Literaturarbeit im Test

Was hilft es wirklich?KI-Tools auf dem Prüfstand

In einer interaktiven Session testeten wir im Team von NextGen verschiedene KI-Tools für die Literaturarbeit. Im Fokus standen dabei nicht nur die technischen Möglichkeiten, sondern vor allem die praktische Anwendbarkeit im Forschungsalltag. Wir führten eine systematische Evaluation – beginnend mit dem Vergleich zu traditionellen Suchmaschinen über Visualisierungstools bis hin zu KI-gestützter Dokumentenanalyse durch.

Der Ansatz war bewusst praxisorientiert: Statt theoretischer Präsentationen standen Live-Demonstrationen und gemeinsame Tests im Mittelpunkt. Jedes der getesteten Tools wurde anhand klarer Kriterien bewertet: Mehrwert gegenüber herkömmlichen Methoden, Effizienz, Qualität der Ergebnisse, Nutzbarkeit und Grenzen.

Was KI anders macht

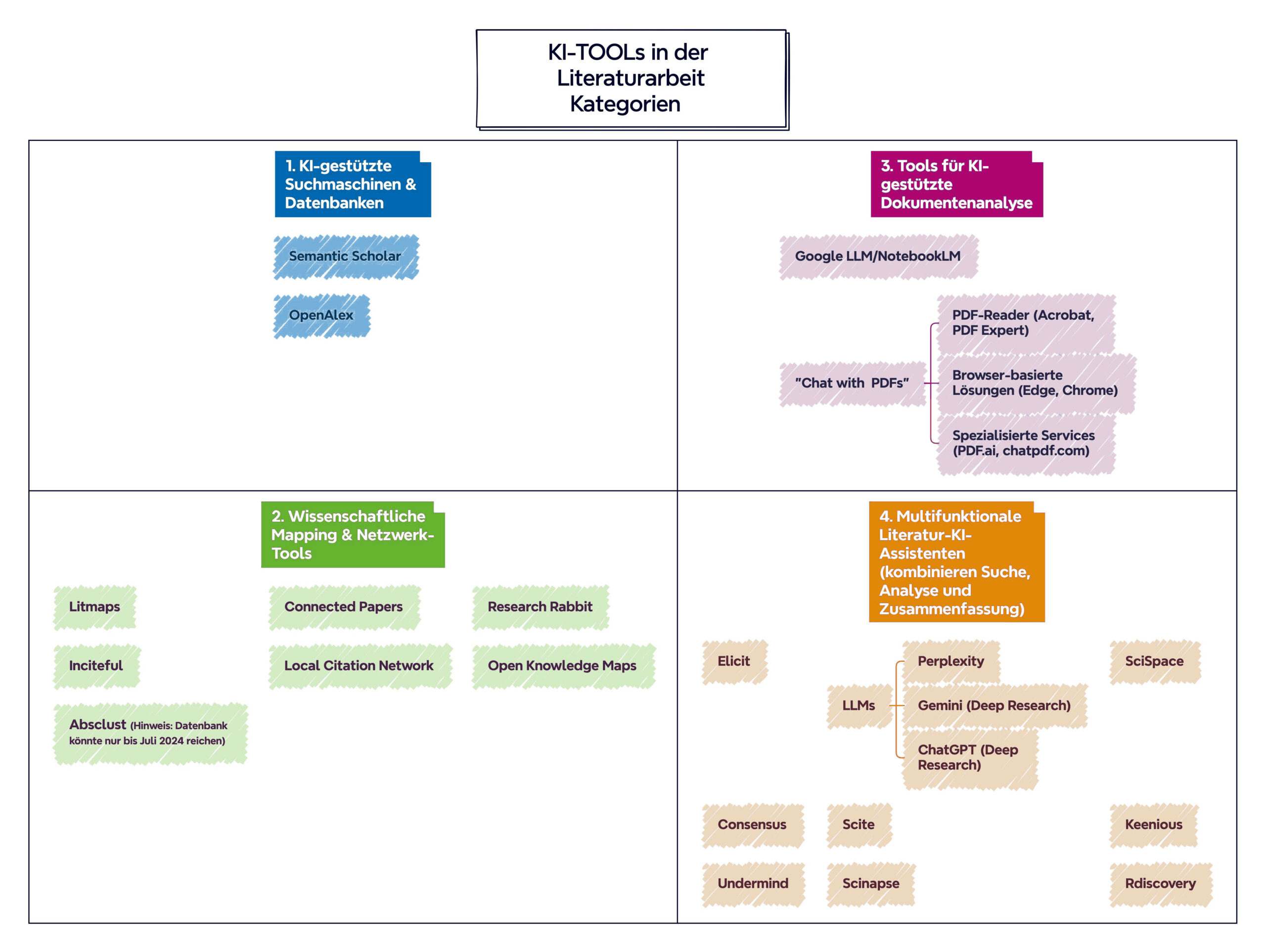

Vier Kategorien, viele Möglichkeiten

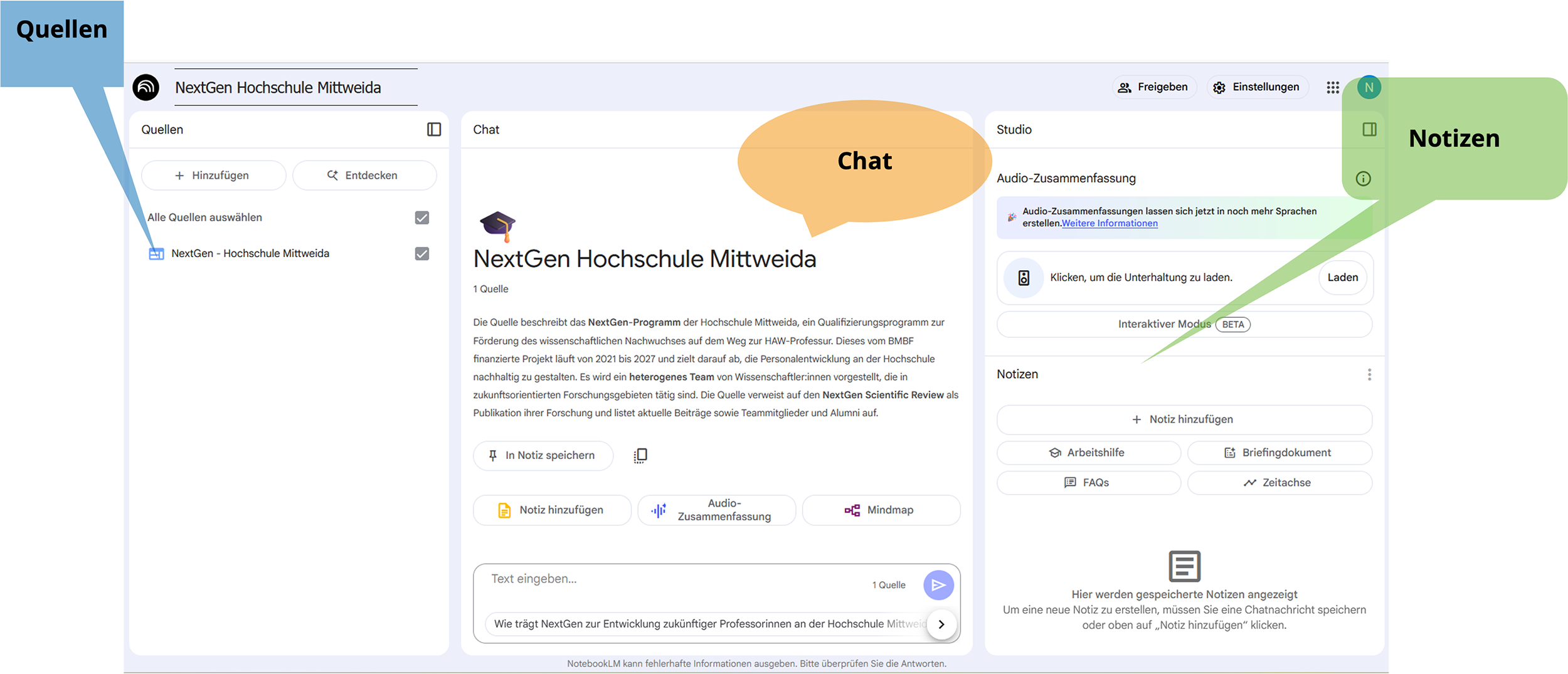

NotebookLM im Fokus

Fazit: Nützliche Helfer mit klaren Grenzen

Das Feedback der Teilnehmenden war differenziert: In puncto Effizienz und Nutzbarkeit schnitten die KI-Tools durchweg gut ab. Besonders geschätzt wurde die Geschwindigkeit bei der Erstellung von Zusammenfassungen und die Möglichkeit, sowohl eine große Anzahl von Dokumenten als auch Dateien mit erheblicher Größe gezielt zu durchsuchen. Bei der Qualität der Ergebnisse zeigte sich jedoch ein gemischtes Bild: Während Korrektheit und Relevanz meist zufriedenstellend waren, blieb die Vollständigkeit problematisch.

Ein zentraler Punkt kristallisierte sich heraus: KI-Tools funktionieren am besten, wenn man bereits Vorwissen mitbringt. Die Tools eignen sich daher weniger für die Erstrecherche in unbekannten Gebieten, sondern vielmehr als intelligente Suchmaschinen für bereits bekannte Literaturbestände.

Ein wichtiger Perspektivwechsel kam aus der Diskussion: Statt KI-Tools isoliert zu nutzen, sollten sie mit bewährten Methoden kombiniert werden. Findet beispielsweise die KI bestimmte Informationen nicht, kann eine gezielte Suche im Original-PDF weiterhelfen. Das Fazit: KI-Tools sind wertvolle Ergänzungen, ohne methodisches wissenschaftliches Arbeiten geht es jedoch nicht!

Die Session machte deutlich: KI-Tools in der Literaturarbeit sind keine Zukunftsmusik mehr, sondern bereits heute praxistauglich - allerdings mit klaren Grenzen. Sie beschleunigen bekannte Arbeitsschritte und eröffnen neue Möglichkeiten der Textanalyse, ersetzen aber nicht die wissenschaftliche Urteilskraft.

Lernen durch Ausprobieren

Ausblick: Eigenes Testen als nächster Schritt

Für die Teilnehmenden ergaben sich konkrete nächste Schritte: Tools wie NotebookLM werden nun in eigenen Projekten getestet, Erfahrungen ausgetauscht und in einem gemeinsamen Wiki dokumentiert - das selbst als NotebookLM-Anwendung realisiert wurde. Die Entwicklung der KI-Landschaft ist so schnelllebig, dass nur durch kontinuierliches Ausprobieren und kritische Bewertung sinnvolle Einsatzszenarien identifiziert werden können.

Die wichtigste Erkenntnis bleibt: KI-Tools sind dann am wertvollsten, wenn sie bewusst und reflektiert eingesetzt werden - als intelligente Assistenten, nicht als Ersatz für wissenschaftliches Denken.